2025年6月に開催されたAppleの年次開発者会議「WWDC25」は、多くのiPhoneユーザーや業界関係者にとって期待外れの内容となりました。注目されていた音声アシスタント「Siri」の生成AIによる大幅な進化は見送られ、あわせて発表された新機能「Apple Intelligence」も、すでに競合他社が展開している技術と大きな差は見られなかったためです。

「Siri」と「Apple Intelligence」は、それぞれAIアシスタントのユーザーインターフェースと、それを支える基盤技術という位置づけですが、いずれも革新性に乏しく、市場の期待に応える内容とは言い難いものでした。生成AIをめぐるグローバルな主導権争いが加速する中で、Appleの慎重な姿勢がむしろ出遅れ感として映ったことは否めません。

結果として「Siriだけでなく、AppleのAI戦略そのものが“オワコン”ではないか」という厳しい声も一部のユーザーから出るほどでした。なぜ、AppleのAI戦略はこれほどまでに苦戦しているのでしょうか。岐路に立つAppleのAI戦略を見ていきましょう。

取り残された『Siri』と先行する競合製品

現在のSiriの機能的な限界は、日常的に利用するユーザーであれば誰もが感じているのではないでしょうか。たとえば、複数の指示にまたがる複雑な文脈の理解は苦手で、「さっき話したレストランの予約、明日の19時に変更して」といった自然な会話の流れについていくことが難しいです。

また、アプリ間のシームレスな連携も不十分で、「LINEでAさんに『今から向かう』と送って、そのあと自宅までの経路をマップで表示して」といった複合的なタスクを一度に処理することはできません。

一方、たとえばGoogleアシスタントは高性能なLLM「Gemini」と統合され、より自然で文脈を理解した対話が可能になっています。AIアシスタントは、もはや単なる「音声コマンドの実行役」ではなく、ユーザーの意図を汲み取り、先回りしてタスクをこなす「知的パートナー」へと進化しつつあります。

この差が、Siriの「時代遅れ感」を一層際立たせているのが現状です。

なぜAppleのAI開発は苦戦しているのか?

AppleがAI開発に苦戦しているさまざまな理由が考えられます。

オンデバイス処理と「プライバシー」へのこだわり

Appleはかねて、ユーザーのプライバシー保護を最優先とする方針を掲げています。その姿勢を具体的に反映しているのが「オンデバイス処理」。これは、iPhoneやMacといった各端末内でAIの処理を完結させ、ユーザーの個人データをクラウドなどの外部サーバーに送信しない技術であり、情報漏洩リスクを最小限に抑える手段として非常に効果的です。

一方で、この仕組みはAI機能の高度化においては大きなハードルともなり得ます。というのも、端末単体で動作するAIには、スマートフォンやPCに内蔵された限られた計算リソースの中で処理を完結させなければならないという制約があるためです。その結果として、他社がクラウドベースで提供している大規模かつ高度なAI機能と比較すると、どうしても実現できる機能に限界が生じます。

例えるなら、限られた食材と調理器具のみで本格的なフルコースを完成させるようなものであり、高度な最適化と技術的工夫が求められます。オンデバイス処理はセキュリティや信頼性の面で優れたアプローチである一方で、生成AI分野における機能の充実や革新性という点では、Appleが他社と同じ土俵で戦うことを難しくしている要因のひとつでもあります。

自社開発モデルへの固執

Appleはこれまで、ユーザーのプライバシーを重視した「オンデバイス処理」や「自社開発による技術提供」に強くこだわってきました。しかし、端末内の限られた計算リソースを活用しながら、高度なAI機能を提供するために、超小型のAIモデルを独自に開発するという方針には技術的困難が伴います。

一方、一部の報道によると、Appleは音声アシスタント「Siri」の再構築にあたり、OpenAIやAnthropicなどの外部AI企業が提供する技術の採用を検討しているとされています。これが事実であれば、長年貫いてきた自社開発主体の戦略から大きく方向転換する可能性を示唆する動きと言えるでしょう。

もっとも、仮に外部の大規模言語モデル(LLM)を採用したとしても、現時点ではそれらをiPhone内のチップのみで処理するのは現実的ではありません。ChatGPTやClaudeに搭載されているような大規模モデルは、通常クラウド上の強力な演算資源を前提として設計されており、スマートフォンのチップでリアルタイムに動作させるには、さらなる高性能化が不可欠です。

Appleが今後、こうした大規模AIモデルを端末内で快適に動作させるために、専用チップの開発に本格的に乗り出すのか、それともクラウドとのハイブリッド型で最適解を探るのか。今後の戦略が注目されます。

『Siri』『Apple Intelligence』は今後どうなる?

『Siri』『Apple Intelligence』の今後については大きく3つの可能性が考えられます。

【1】現行路線の継続

1つ目は、プライバシーを最優先する「オンデバイスでのAI処理」と「自社開発」路線を継続するという選択肢。これはAppleのブランド哲学を守る上では最も正攻法ですが、開発の後れを取り戻すことや市場が求めるレベルのAI機能を実現するハードルは高いでしょう。

【2】オンデバイス処理と外部AIの連携

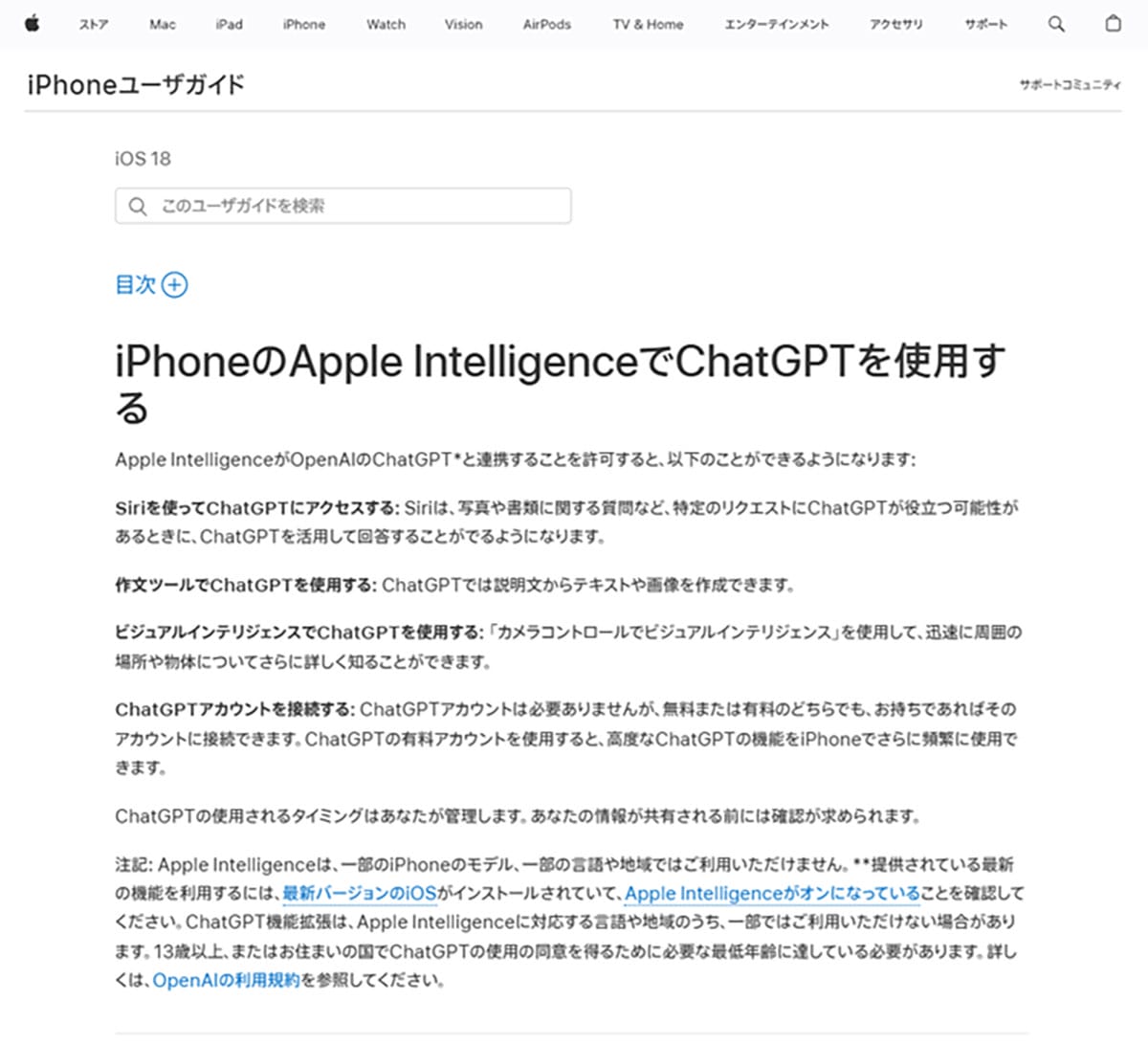

2つ目は、現在も一部で採用しているハイブリッド戦略をさらに深化させる道です。つまり、日常的なタスクは自社のオンデバイスAIで処理しつつ、高度な生成AI機能については、ユーザーの同意を得た上で外部AI(ChatGPTなど)を呼び出すという形です。

しかし。「Siriに話しかけているつもりが、実はChatGPTと話していた」という状況は、ユーザー体験の一貫性を損なう可能性もあるでしょう。また、外部AIの利用料など、コスト面での課題も浮上します。

【3】外部AIへの完全移行

3つ目の選択肢として挙げられるのが、自社開発を断念し、音声アシスタント「Siri」の中核となるエンジンを、OpenAIやAnthropicといった外部の高性能なAI技術に全面的に置き換えるという方針となります。しかしこの判断は、長年こだわってきた自社技術による独自路線を放棄することを意味し、Appleとしては大きな決断となります。

加えて、Appleがこれまで重視してきたプライバシー保護の理念を維持するには、自社と同等レベルでデータ管理体制を徹底できる外部パートナーを見極める必要があります。信頼性やセキュリティの観点からも、連携先の選定は極めて慎重に行う必要があるでしょう。

また、ハイブリッド型の運用と同様、このケースでも外部AIサービスの利用に伴うコストが新たな課題となります。特に、大規模モデルをAPI経由で頻繁に活用する場合、膨大なライセンス料や通信コストが発生する可能性があります。

今後、Appleは「プライバシーという聖域」を守りながら性能向上を目指すのか、それともプライドを捨てて外部の高性能AIに頼るのか、あるいはその間で難しいバランスを取り続けるのか、という重大な選択を迫られていると言えるでしょう。

※サムネイル画像(Image:DenPhotos / Shutterstock.com)